Как установить Apache Spark на Debian 10

В этом руководстве мы покажем вам, как установить Apache Spark на Debian 10. Для тех из вас, кто не знал, Apache Spark — это быстрая и универсальная кластерная вычислительная система. Он предоставляет высокоуровневые API-интерфейсы на Java, Scala и Python, а также оптимизированный движок, поддерживающий общие диаграммы выполнения. Он также поддерживает богатый набор инструментов более высокого уровня, включая Spark SQL для SQL и обработки структурированной информации, MLlib для машинного обучения, GraphX для обработки графиков и Spark Streaming.

В этой статье предполагается, что у вас есть хотя бы базовые знания Linux, вы знаете, как использовать оболочку, и, что наиболее важно, вы размещаете свой сайт на собственном VPS. Установка довольно проста и предполагает, что вы работаете с учетной записью root, в противном случае вам может потребоваться добавить ‘ sudo‘ к командам для получения привилегий root. Я покажу вам пошаговую установку Apache Spark на Debian 10 (Buster).

Установите Apache Spark на Debian 10 Buster

Шаг 1. Перед запуском приведенного ниже руководства важно убедиться, что ваша система обновлена, выполнив следующие aptкоманды в терминале:

sudo apt update

Шаг 2. Установка Java.

Apache Spark требует для запуска Java, давайте убедимся, что Java установлена в нашей системе Debian:

sudo apt install default-jdk

Проверьте версию Java с помощью команды:

java -version

Шаг 3. Установка Scala.

Теперь устанавливаем пакет Scala в системы Debian:

sudo apt install scala

Проверьте версию Scala:

scala -version

Шаг 4. Установка Apache Spark в Debian.

Теперь мы можем скачать двоичный файл Apache Spark:

wget https://www.apache.org/dyn/closer.lua/spark/spark-3.1.1/spark-3.1.1-bin-hadoop2.7.tgz

Затем распакуйте архив Spark:

tar xvf spark-3.1.1-bin-hadoop2.7.tgz sudo mv spark-3.1.1-bin-hadoop2.7/ /opt/spark

После этого установите среду Spark:

nano ~/.bashrc

В конце файла добавьте следующие строки:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Сохраните изменения и закройте редактор. Чтобы применить изменения, выполните:

source ~/.bashrc

Теперь запустите Apache Spark с помощью этих команд, одна из которых является главной для кластера:

start-master.sh

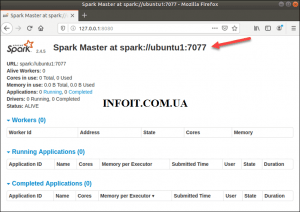

Чтобы просмотреть пользовательский интерфейс Spark Web, как показано ниже, откройте веб-браузер и введите IP-адрес localhost на порт 8080:

http://127.0.0.1:8080/

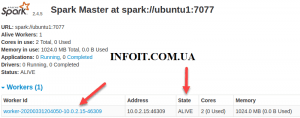

В этой автономной установке с одним сервером мы запустим один подчиненный сервер вместе с главным сервером. Команда используется для запуска рабочего процесса Spark:start-slave.sh

start-slave.sh spark://ubuntu1:7077

Теперь, когда воркер запущен и работает, если вы перезагрузите веб-интерфейс Spark Master, вы должны увидеть его в списке:

После завершения настройки запустите главный и подчиненный сервер, проверьте, работает ли оболочка Spark:

spark-shell

Поздравляю! Вы успешно установили Spark . Благодарим за использование этого руководства для установки последней версии Apache Spark в системе Debian. Для получения дополнительной помощи или полезной информации мы рекомендуем вам посетить официальный сайт Apache Spark .