Как установить Apache Spark на Debian 11

В этом руководстве мы покажем вам, как установить Apache Spark на Debian 11. Для тех из вас, кто не знал, Apache Spark — это бесплатная универсальная среда с открытым исходным кодом для кластерных вычислений. Он специально разработан для обеспечения скорости и используется в машинном обучении для потоковой обработки сложных SQL-запросов. Он поддерживает несколько API-интерфейсов для потоковой передачи и обработки графиков, включая Java, Python, Scala и R. Spark в основном устанавливается в кластерах Hadoop, но вы также можете установить и настроить Spark в автономном режиме.

В этой статье предполагается, что у вас есть хотя бы базовые знания Linux, вы знаете, как использовать оболочку, и, что наиболее важно, вы размещаете свой сайт на собственном VPS. Установка довольно проста и предполагает, что вы работаете с учетной записью root, в противном случае вам может потребоваться добавить ‘ sudo‘ к командам для получения привилегий root. Я покажу вам пошаговую установку Apache Spark на Debian 11 (Bullseye).

Установите Apache Spark на Debian 11 Bullseye

Шаг 1. Перед установкой любого программного обеспечения важно убедиться, что ваша система обновлена, выполнив следующие aptкоманды в терминале:

sudo apt update sudo apt upgrade

Шаг 2. Установка Java.

Выполните следующую команду ниже, чтобы установить Java и другие зависимости:

sudo apt install default-jdk scala git

Проверьте установку Java с помощью команды:

java --version

Шаг 3. Установка Apache Spark в Debian 11.

Теперь скачиваем последнюю версию Apache Spark с официальной страницы с помощью wgetкоманды:

wget https://dlcdn.apache.org/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

Затем распакуйте загруженный файл:

tar -xvzf spark-3.1.2-bin-hadoop3.2.tgz mv spark-3.1.2-bin-hadoop3.2/ /opt/spark

После этого отредактируйте файл и добавьте переменную пути Spark:~/.bashrc

nano ~/.bashrc

Добавьте следующую строку:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Сохраните и закройте файл, затем активируйте переменную среды Spark, используя следующую команду:

source ~/.bashrc

Шаг 4. Запустите главный сервер Apache Spark.

На этом этапе Apache Spark установлен. Теперь давайте запустим его автономный главный сервер, запустив его скрипт:

start-master.sh

По умолчанию Apache Spark прослушивает порт 8080. Вы можете проверить это с помощью следующей команды:

ss -tunelp | grep 8080

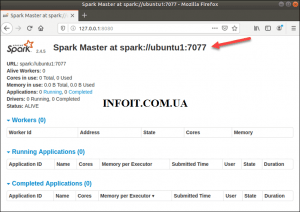

Шаг 5. Доступ к веб-интерфейсу Apache Spark.

После успешной настройки перейдите к веб-интерфейсу Apache Spark с помощью URL-адреса . Вы должны увидеть главную и подчиненную службу Apache Spark на следующем экране:http://your-server-ip-address:8080

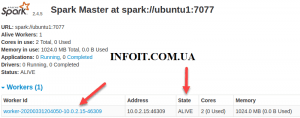

В этой автономной установке с одним сервером мы запустим один подчиненный сервер вместе с главным сервером. Команда используется для запуска искрового Рабочий процесс:start-slave.sh

start-slave.sh spark://ubuntu1:7077

Теперь, когда воркер запущен и работает, если вы перезагрузите веб-интерфейс Spark Master, вы должны увидеть его в списке:

После завершения настройки запустите главный и подчиненный сервер, проверьте, работает ли оболочка Spark:

spark-shell

Вы получите следующий интерфейс:

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 3.1.2

/_/

Using Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.12)

Type in expressions to have them evaluated.

Type :help for more information.

scala>

Поздравляю! Вы успешно установили Apache Spark . Благодарим за использование этого руководства для установки последней версии Apache Spark на Debian 11 Bullseye. Для получения дополнительной помощи или полезной информации мы рекомендуем вам посетить официальный сайт Apache Spark .