Как установить Apache Spark в Ubuntu 20.04 LTS

В этом руководстве мы покажем вам, как установить Apache Spark в Ubuntu 20.04 LTS. Для тех из вас, кто не знал, Apache Spark — это быстрая и универсальная кластерная вычислительная система. Он предоставляет высокоуровневые API-интерфейсы на Java, Scala и Python, а также оптимизированный движок, поддерживающий общие диаграммы выполнения. Он также поддерживает богатый набор инструментов более высокого уровня, включая Spark SQL для SQL и обработки структурированной информации, MLlib для машинного обучения, GraphX для обработки графиков и Spark Streaming.

В этой статье предполагается, что вы имеете хотя бы базовые знания Linux, знаете, как использовать оболочку, и, что наиболее важно, размещаете свой сайт на собственном VPS. Установка довольно проста и предполагает, что вы работаете с учетной записью root, в противном случае вам может потребоваться добавить ‘ sudo‘ к командам для получения привилегий root. Я покажу вам пошаговую установку Apache Spark на сервере 20.04 LTS (Focal Fossa). Вы можете следовать тем же инструкциям для Ubuntu 18.04, 16.04 и любого другого дистрибутива на основе Debian, например Linux Mint.

Установите Apache Spark на Ubuntu 20.04 LTS Focal Fossa

Шаг 1. Во-первых, убедитесь, что все ваши системные пакеты обновлены, выполнив следующие aptкоманды в терминале.

sudo apt update sudo apt upgrade

Шаг 2. Установка Java.

Apache Spark требует для запуска Java , давайте убедимся, что Java установлена в нашей системе Ubuntu:

sudo apt install default-jdk

Мы проверяем версию Java с помощью командной строки ниже:

java -version

Шаг 3. Загрузите и установите Apache Spark.

Загрузите последнюю версию Apache Spark со страницы загрузок :

wget https://www.apache.org/dyn/closer.lua/spark/spark-3.0.0/spark-3.0.0-bin-hadoop2.7.tgz tar xvzf spark-3.0.0-bin-hadoop2.7.tgz sudo mv spark-3.0.0-bin-hadoop2.7/ /opt/spark

Затем настраиваем Apache Spark Environment:

nano ~/.bashrc

Затем добавьте эти строки в конец файла .bashrc, чтобы путь мог содержать путь к исполняемому файлу Spark:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Активируйте изменения:

source ~/.bashrc

Шаг 4. Запустите автономный главный сервер Spark.

Теперь, когда вы завершили настройку своей среды для Spark, вы можете запустить главный сервер:

start-master.sh

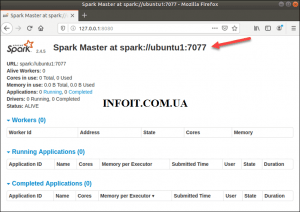

Чтобы просмотреть пользовательский интерфейс Spark Web, откройте веб-браузер и введите IP-адрес localhost на порту 8080:

http://127.0.0.1:8080/

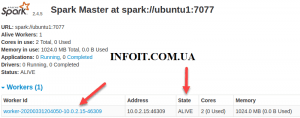

В этой автономной установке с одним сервером мы запустим один подчиненный сервер вместе с главным сервером. Команда используется для запуска рабочего процесса Spark:start-slave.sh

start-slave.sh spark://ubuntu1:7077

Теперь, когда воркер запущен и работает, если вы перезагрузите веб-интерфейс Spark Master, вы должны увидеть его в списке:

После этого завершите настройку и запустите главный и подчиненный сервер, проверьте, работает ли оболочка Spark:

spark-shell

Поздравляю! Вы успешно установили Apache Spark . Благодарим за использование этого руководства по установке Apache Spark в системе Ubuntu 20.04 (Focal Fossa). Для получения дополнительной помощи или полезной информации мы рекомендуем вам посетить официальный сайт Apache Spark .